GPT-4o的概念详解

GPT-4o代表OpenAI最新的人工智能模型,它具备了处理和反馈语音、文本和视觉信息的多模态推理能力。该模型致力于提供更加自然和富有情感表达的交互体验。它的设计侧重于提高运算速度并降低成本。值得注意的是,其运作速度是其前身模型的两倍,成本却只有一半。GPT-4o在多语言处理、音频和视觉理解方面有出色的表现,同时还强化了安全性设计,以确保交互过程的安全性。在ChatGPT平台上,其文本和图像功能已经逐步发布,用户可以免费体验。而后续音频和视频功能的推出也在计划中。

GPT-4o的主要亮点

首先,多模态交互是GPT-4o的重要特点。除了处理文本信息外,它还可以处理语音和视觉信息,帮助理解和回应更广泛的用户需求,包括实时视频分析。

其次,实时响应是另一个重点。无论是文本对话、语音交互还是视频内容分析,GPT-4o都能快速给出反馈。对音频输入的反应时间极短,平均为320毫秒,几乎接近人类的反应时间。

再来,GPT-4o拥有情感识别与模拟能力,能够识别并模拟用户的情感状态,使得交流体验更加真实和自然。

另外,对于编程代码的理解与解析能力也是GPT-4o的一大亮点,它可以帮助用户理解代码的功能和逻辑,对于代码的问题提供语音回答并解释代码的工作原理。

最后,GPT-4o还支持超过50种语言,可以服务全球用户,同时提供实时同声传译服务。

GPT-4o的表现及优势

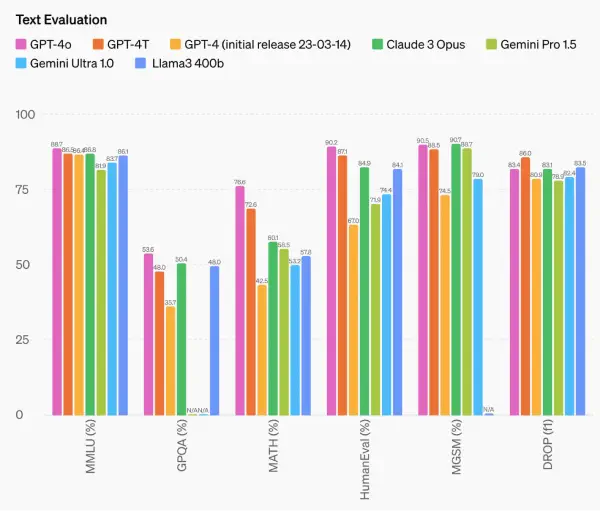

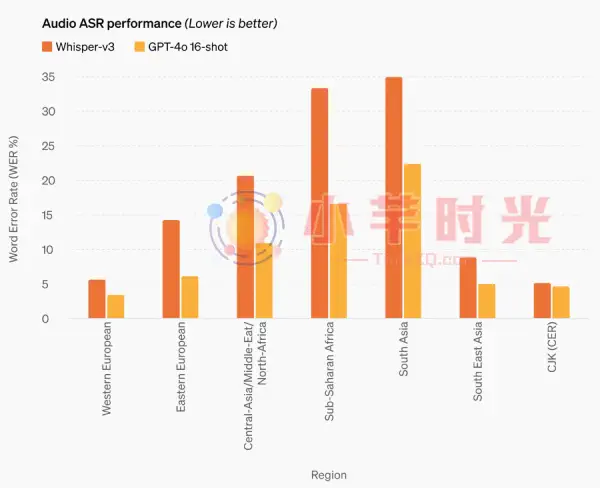

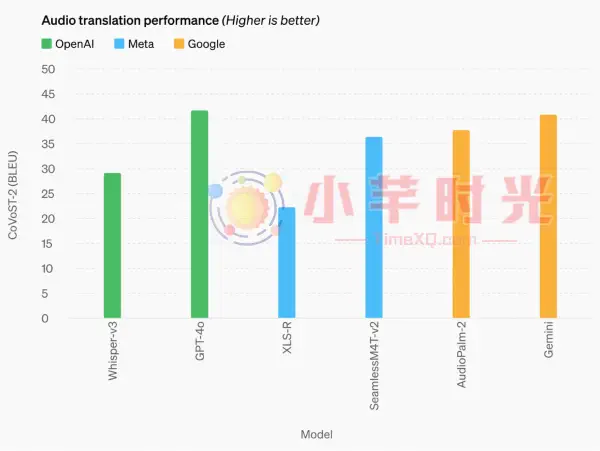

从表现来看,GPT-4o在多语言理解均值(MMLU)基准测试中创下了87.2%的最高得分,GPQA得分为53.6%排名第一、MATH得分76.6%排名第一、HumanEval得分90.2%排名第一、MGSM得分90.5%排名第二,透露出其强大的文本处理能力。至于音频识别方面,gpt-4o在所有语言中的性能都显著优于Whisper-v3。同时,它在视觉理解评估方面也展示出了最先进的表现,领先于其他模型。

相较于GPT-4 Turbo,GPT-4o更为出色。从价格上看,它比GPT-4 Turbo减少了50%的成本。同时,其处理速度也是GPT-4 Turbo的5倍,可以每分钟处理1000万个token。而在视觉能力的评估和测试中,GPT-4o也比GPT-4 Turbo表现得更好。最后,GPT-4o在非英语语言的支持上做出了改进,为全球用户提供了更优质的服务。

如何使用GPT-4o

要想使用GPT-4o,你可以在ChatGPT平台上试用,其中的文本和图像功能对所有用户都开放。同时,OpenAI还计划在未来几周内为Plus用户推出基于GPT-4o的Voice Mode的新版本。此外,开发者也可以通过API接口将GPT-4o集成到他们的应用程序中,以获取更快速、更便宜而且有更高速率限制的服务。而更深层次的音频和视频功能,OpenAI将在确保技术基础设施、性能和安全性等方面无大问题后,逐步向公众开发。希望这些信息可以帮助你更好地理解和使用 GPT-4o。